介绍

参考 https://halide-lang.org/ 和 http://stellar.mit.edu/S/course/6/sp15/6.815/courseMaterial/topics/topic2/lectureNotes/14_Halide_print/14_Halide_print.pdf。

Halide 的核心思想是把图像处理(可以理解为矩阵运算)的算法(需要计算什么内容)和调度(如何优化执行计算)分开。

WHY

大规模的矩阵运算性能优化空间很大,但是目前已有的人工优化和编译器优化都有一些问题。

人工优化,有两种范式,一种是针对具体的场景手工优化,一种是提供BLAS, IPP, MKL, OpenCV这类高度优化的库。前一种效率太低(场景众多,还要针对不同的后端硬件,优化工作量太大),后者则只能提供局部最优的模块,无法在全局进行调度和融化优化。

编译器优化,可以看见完整的运算pipeline,但是优化的效果相对手动优化差了很多(就是一个最简单的矩阵乘法,编译器的输出都可能比手工优化要慢数倍)。同时,编译器中的很多核心优化决策都没有开放外部控制(比较典型的是,连循环展开的次数,GCC等编译器都是最近几年才通过#pragma unroll等方式提供了支持,更不要说直接控制cache block的大小等等),这导致在编译器的基础上人工再调优(纠正编译器的错误优化决策)很困难。

综合以上信息,高效和高质量的全局优化,还是要靠编译器。Halide的创造者也是沿着这个思路解决问题。

WHAT

Halide 是一种DSL(领域语言),也是该DSL的编译器。

它的核心思想是把运算的逻辑和运算的过程分离。将运算过程剥离出后,再将各个典型优化决策的控制变量和控制逻辑暴露出来,以便人工或者黑盒优化算法(如遗传算法等)能持续调整优化决策,达到更好的性能。

它主页中的示例代码很好的说明了其思想,如下所示。

1 | Func blur_3x3(Func input) { |

上面代码将blur的运算逻辑,与具体运算的实施过程进行了分离。用很简单的几个方法就指定了tile/vectorize等重要优化,以及其对应的参数。直观看起来,代码很简洁,并且要修改优化的类型和参数,工作量也很小。

而要迫使编译器实现同样的优化,需要写下面一大段代码。

并且,这样的代码由于直接使用intel 的SIMD原语,可移植性大幅度下降。

更加严重的是,想要微调各项优化参数(为了针对不同的硬件做优化),都需要对代码做大幅度的修改,工作量很大。

而上面的Halide代码,只需修改几个入参就可以完成优化决策的调整。哪怕Halide不提供内置的autotuner,使用一个简单的python脚本接入opentuner等黑盒优化框架也都会非常简单(毕竟只是改几个参数而已)。

1 | void box_filter_3x3(const Image &in, Image &blury) |

HOW

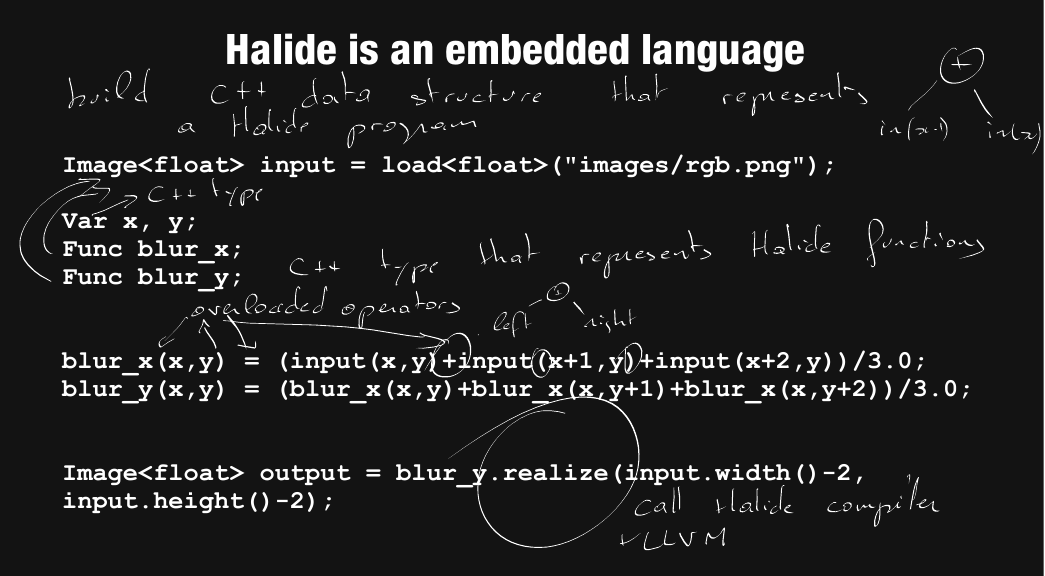

Halide介绍ppt中的一页示意图很好地展示了它的工作过程。

图中飘逸的寥寥几笔注释已经把核心的工作原理讲清楚了。

如果对编译技术比较熟悉,看完注释后最核心的几个疑问应该就豁然开朗了。

简单的说,Halide语言没有独立的语法定义,也就不需要独立的lexer和parser。

它利用了C++语言的元编程能力,直接构造出了Halide语言的中间表达IR。

具体情况,随后一节会有详细的分析。

语言实现分析

为了分析Halide编译器的具体实现,下载并编译了Halide的代码(使用Ubuntu18.04自带的clang/llvm8,按照官方命令编译,比较简单)。

然后编译、运行和调试其tutorial目录中的各个示例。

可以对其实现有一个大致的了解。

语言定义

从最简单的示例入手,理解整体概念更容易。

参考下面代码注释。

1 | //这个示例用Halide完成了一个矩阵 |

总结一下,Halide的核心概念就是Func、Var和Expr。它没有文本源代码的格式,直接是寄生在C++上。Func、Var和Expr都是C++的class。在完成声明和赋值的同时,利用对=、+和()的重载,完成了Halide的IR构建。

编译、调试和源码分析

编译准备

Halide的编译只需要依赖LLVM,在ubuntu18.04上安装llvm8就可以了。

clone下Halide代码后,进入目录后执行如下命令,可构建出带有调试信息的版本。

1 | mkdir build |

编译示例并调试

Halide 前端

在上一步构建完成的build目录中,继续执行如下命令。

1 | cd distrib/tutorial/ |

这个lesson01就是前面语言定义一节中已经给出过的示例代码。

由于Function和Var的定义都没有传参,可以跳过,直接单步跟踪expr的赋值。这里给出的结果就非常典型了。

首先变量x和y被转换为了Expr。

1 | 15518 /** A Var can be treated as an Expr of type Int(32) */ |

然后Expr的operator+,就调用了Internal::Add::make构建了Expr这个IR。

1 | 1139 Expr operator+(Expr a, Expr b) { |

调试到这里已经基本能确认Halide前端的工作原理了,通过operator重载,Halide直接构造了IR的,跳过了Lexer和Parser部分。

下一个问题是,Halide的IR如何,或者在什么时机进行Codegen。

Halide的代码生成流程

如前所述,Halide中通过realize方法完成了代码的编译和运行。接着调试上面程序的gradient.realize调用。

可以看到如下的调用链条。

1 | #0 Halide::Internal::lower (output_funcs=std::vector of length 1, capacity 1 = {...}, pipeline_name="f0", t=..., args=std::vector of length 1, capacity 1 = {...}, |

看到lower,老司机应该已经心领神会找到门路了。一般lower意味着高层表达向硬件层级扩展,表达的内容将越发具体完整。

lower函数的过程,可以看到大致有两个主要的工作,第一个是补充最终程序需要的系列流程,如初始化环境,建立循环,已经插入一些等等;第二个是进行各项高层优化(优化越接近源码,执行起来越简单。)。但是lower部分看到结尾,仍然没有向另外一种IR或者机器指令转换。

从lower返回后,在compile_jit函数中继续向下调试,可以最终找到如下堆栈回溯中,Halide完成了IR到LLVM-IR的codegen过程(当然如果结合代码分析,查找LLVM的相关流程,找到这里会更快)。

#0 Halide::Internal::CodeGen_LLVM::compile (this=0x5555557b60e0, input=…)

at /media/majiang/c6b38ac3-8b8a-4613-8259-dddbffe2f4cb/majiang/opensource/Halide/src/CodeGen_LLVM.cpp:637

#1 0x00007ffff399a42c in Halide::codegen_llvm (module=…, context=…)

at /media/majiang/c6b38ac3-8b8a-4613-8259-dddbffe2f4cb/majiang/opensource/Halide/src/CodeGen_LLVM.cpp:46

#2 0x00007ffff3c326e1 in Halide::compile_module_to_llvm_module (module=…, context=…)

at /media/majiang/c6b38ac3-8b8a-4613-8259-dddbffe2f4cb/majiang/opensource/Halide/src/LLVM_Output.cpp:381

#3 0x00007ffff3c13c91 in Halide::Internal::JITModule::JITModule (this=0x7fffffffbf90, m=…, fn=…, dependencies=std::vector of length 0, capacity 0)

at /media/majiang/c6b38ac3-8b8a-4613-8259-dddbffe2f4cb/majiang/opensource/Halide/src/JITModule.cpp:251

#4 0x00007ffff3cb86dd in Halide::Pipeline::compile_jit (this=0x7fffffffd920, target_arg=…)

at /media/majiang/c6b38ac3-8b8a-4613-8259-dddbffe2f4cb/majiang/opensource/Halide/src/Pipeline.cpp:607

#5 0x00007ffff3cbbda7 in Halide::Pipeline::realize (this=0x7fffffffd920, outputs=…, t=…, param_map=…)

at /media/majiang/c6b38ac3-8b8a-4613-8259-dddbffe2f4cb/majiang/opensource/Halide/src/Pipeline.cpp:1099

#6 0x00007ffff3cb98b0 in Halide::Pipeline::realize (this=0x7fffffffd920, sizes=std::vector of length 2, capacity 2 = {…}, target=…, param_map=…)

at /media/majiang/c6b38ac3-8b8a-4613-8259-dddbffe2f4cb/majiang/opensource/Halide/src/Pipeline.cpp:703

#7 0x00007ffff3ac078c in Halide::Func::realize (this=0x7fffffffdbf0, sizes=std::vector of length 0, capacity 0, target=…, param_map=…)

at /media/majiang/c6b38ac3-8b8a-4613-8259-dddbffe2f4cb/majiang/opensource/Halide/src/Func.cpp:2922

#8 0x00007ffff3ac0a7d in Halide::Func::realize (this=0x7fffffffdbf0, x_size=800, y_size=600, target=…, param_map=…)

at /media/majiang/c6b38ac3-8b8a-4613-8259-dddbffe2f4cb/majiang/opensource/Halide/src/Func.cpp:2937

#9 0x000055555555d56a in main (argc=1, argv=0x7fffffffdd98) at lesson_01_basics.cpp:78

后面的流程更加直接一些,CodeGen_LLVM.cpp包含了主要的转换内容,compile_func中的 f.body.accept(this); 发起了LLVM-IR的发射动作。

后面就是CodeGen_LLVM.cpp中的一堆visit函数完成了针对不同类型Halide IR的LLVMIR代码生成。

遗留的学习

Halide自带的autotuner如何工作?

有意思的一些编程技巧

1 把可变参数的输入转成vector处理

1 | template<typename... Args> |

2 在父类中访问子类成员

https://en.wikipedia.org/wiki/Curiously_recurring_template_pattern

Typically, the base class template will take advantage of the fact that member function bodies (definitions) are not instantiated until long after their declarations, and will use members of the derived class within its own member functions, via the use of a cast; e.g.:

1 | template <class T> |